您现在的位置是:首页 > 社会动态 > 正文 社会动态

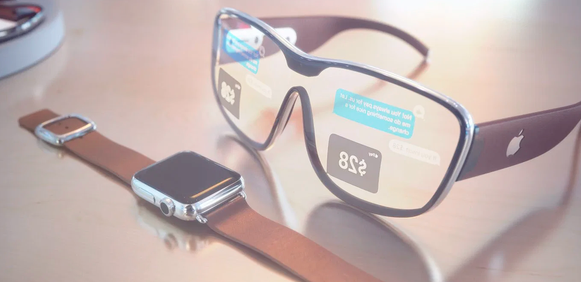

iOS 14悄悄地向Apple Glasses迈出了一大步

发布时间:2021-03-05 12:03:25来源:

苹果在2020年全球开发者大会(WWDC)上宣布了各种操作系统的大量更新,但没有提及任何新硬件。但是,已经关注WWDC一段时间的人们会知道,隐藏在软件公告中的小技巧几乎可以揭示设备的下一步发展。

从表面上看,这完全是关于iOS 14的,苹果转向了ARM和自己的硅芯片等,但在此之下,所有迹象都清楚表明您可能会错过苹果眼镜。

苹果在谈论iOS 14或iPadOS时几乎没有提到增强现实(AR),但是如果将一些单独的声明放在一起,那么就会出现更清晰的画面。例如-AirPods Pro上的空间音频,面向开发人员的基于位置的AR工具,应用程序剪辑,Apple Vision和3D图标的“手势”检测。

有了这么多的小提示和线索,您所需要的只是那些智能眼镜,以使它们融合在一起。

首先,ARKit4。ARKit是面向AR应用程序开发人员的一组工具,苹果公司表示,它为全球最大的AR平台-iOS提供动力。您不会将iOS视为AR平台,因为该技术仍非常非常新生。但是,ARKit演示之一显示了新的“定位锚”,该定位锚指向iOS 14和iPadO 14的情况将如何变化。

这些位置锚使应用程序可以在现实世界中的特定位置放置AR创建物,例如路标,雕像,甚至游戏角色。这是苹果公司迈出的第一步,在所有这些地方,戴着苹果眼镜的人都可以看到这些虚拟的路标和物体。

除了Pokemon Go这样的游戏外,我们还没有真正看到AR在现实世界中迈出一步。宜家只是在您的客厅里移动虚拟家具。苹果已经将LiDAR技术用于其新iPad中。

在iOS 14和iPadOS 14设备上,ARKit 4可以将来自Apple Maps的地理坐标和高分辨率地图数据放在一起。ARKit工程师Quinton Petty称之为“可视化本地化”,这意味着您将能够比仅使用GPS数据更精确地相对于周围环境精确定位设备。这对于AR体验是有意义的。苹果还表示,其所有基于位置的AR均使用在您的设备上运行的先进的机器学习技术,并且云中没有任何处理,苹果也不会向自己或其他任何人发送任何图像。

除了这些“定位锚”之外,AR主题还有一个微妙的点头,因此,智能眼镜是AirPods Pro的空间音频功能。此更新为您的耳塞带来了3D声音。除非您带着AirPods观看许多杜比全景声(Dolby Atmos)轻弹,否则为什么耳塞需要3D声音。

此更新的真正好处可能是手机附带了AR,可让您向地图上的音频点头,从而在Apple Glasses眼镜上为您提供路线或AR。

就App Clip而言,这完全是直接的好处,例如无需实际下载完整的应用程序就付款,但最终目的似乎是帮助您通过扫描实际对象来启动AR体验。然后在Apple的Vision框架中实现了手势控制的“手势”识别,在ARKit 4中使用“ LiDAR”对不同对象和材料进行分类的“场景几何”。

标签:

猜你喜欢

- Flipkart揭示了2021年值得关注的智能手机热门趋势

- 今日欧元美元汇率走势图分析及操作建议(202138)

- 十年与受其固定生命周期策略管理的大多数Microsoft产品一致

- 3月8日恒源石化石油焦报价平稳

- 小编解答oppoa11语音助手怎么语音唤醒

- 微软与Internet Explorer进行告别

- 工商银行莫名其妙多了一张卡里面还有钱,去银行取还冻结了,怎么样

- 原材料为什么会在年后一直上涨

- 如何从谷歌获得免费的家庭电话服务

- 2月25日蓝星哈尔滨苯酚价格稳定

- Android 11从iPhone借鉴了五个新功能

- 小米手表Lite和红米手表有什么不同

- 晚内参:ETC Group将推出以太坊ETP Argo将建新矿场

- 带有数字小键盘的Satechi铝合金蓝牙键盘评测

- 三星的首款可折叠智能手机GalaxyFold已售出100万部

- Realme X50 Pro 5G配备65W SuperDart Charge技术与双打孔相机

最新文章

- 美好蕴育打造中国首个孕产妈妈解压音乐现场,等你来!

- 亚洲航空的前景在主要市场重新开放后有所改善

- 由于主要市场的重新开放 亚航的前景有所改善

- 中广核-CIMB研究对赛迪亚战略持乐观态度

- 为什么公司的国内毛利是其增长前景的关键?

- iQOONeo5将配备全覆盖液冷散热系统

- 魅族18Pro定位年度极致旗舰魅族18则定位为小屏满血旗舰

- 苹果今日正式发布了iOS14.5和iPadOS14.5第五个测试版

- realme举办新品发布会正式发布了GT系列首款产品

- iPadPro312.9英寸版本搭载的是苹果A12X仿生芯片

- 三星S21Ultra系列还拥有一颗全新的一亿像素主摄

- realmeC21配备了一块6.5英寸HD显示屏

- SnapdragonSound技术可以为用户提供更稳定的无线连接体验

- 小米本次推送的系统版本号是MIUIV12.0.5.0.RKHCNXM

- 魅族18系列双旗舰5G手机正式发布

- 小米11Pro采用了跟小米11差不多的后置摄像头设计

- 外媒还带来了iPhone14手机的设计渲染图

- iPhone12mini具有很好的音色出色的空间感

- CNET称三星GalaxyS21Ultra为顶级安卓手机

- 腾讯红魔游戏手机6系列此次全系配备了骁龙888LPDDR5内存UFS3.1闪存

- 三星Galaxy Xcover5搭载了Exynos850芯片

- 小米10S将换装骁龙865的升级版骁龙870

- 定制版iPhone12 Pro和iPadPro机身表面都印有金苹果树

- 中兴天机Axon205G的照片得分为89分

随机图文

全网一家亲背后 亲缘性社交符号怎么火起来的

崽崽妈妈爱你!爱豆发微博的第一秒,小派就冲进评论区抢占先地。留完言,她刷新首页,看见一条女孩喂养校园流浪猫的小视频。小姐姐真是人美

行业处于收缩期 重仓精选项目是更合理的策略

大家会有区块链行业发展缓滞的感觉吗?我是说,透过 Libra、行情这些热点和噪声,矿业与交易所格局稳固,公链和协议层缺乏创新,杀手级应用

投资中的 Vintage Year 人 机构和公司都是要看年份的

好酒是看年份的,也就是所谓的 Vintage Year。好的年份,阳光好、温度好、葡萄产量充足又饱满,酿出来的葡萄酒就更加好喝,所以千万别误

打响产业互联网进阶战 找钢网王东 科技是最大筹码

互联网时代到来时,钢铁电商模式的兴起让传统钢铁行业逐渐摆脱傻大黑粗的标签,开始讲述一段新故事。而随着产业互联网概念兴起,越来越多的